Ich fahre viel Fahrrad in Wien. Wien – diese Stadt, die überall über den Klee gelobt wird, wenn man aber genauer hinschaut sieht man, in was für Kompromissen gute Dinge erkauft wurden. Gerade bei Radstraßen und der Radwegeführung sieht man das oft. Wie gibt sich als Radstadt, aber die Schritte sind klein um bloß niemandem auf die Füße zu treten. Drei Beispiele aus meinem Alltag möchte ich hier kurz beschreiben.

Grasbergergasse

Die Grasbergergasse ist eine kleine Straße mit einseitigem Radweg zwischen einem Kreisel und Rennweg und ist Teil des Tram-Wendekreises an der Station St Marx. Kommt man von der Station St. Marx wird der Radweg erst über einen Parkplatz geleitet, dann als Teil des Zebrastreifen am Kreisel auf die andere Straßenseite, biegt nach links an der Grasbergergasse entlang. Aus der Richtung kommen ist es okay.

Anders, wenn man vom Rennweg kommt. Radweg ist auf der linken Seite, man fährt auf den Kreisel zu und biegt nach Rechts auf die Radspur des Zebrastreifen vor dem Greisel. Früh muss man anzeigen, dass man hier rechts abbiegen will, wenn man irgend eine Chance haben will, das Autofahrer*Innen aus dem Kreisel kommend am Zebrastreifen halten. Fast wöchentlich hab ich hier Situationen, das Autofahrer denken hier noch durchhuschen zu können und mich zur Vollbremsung zwingen. Bei viel Verkehr ist es auch beliebt einfach auf dem Zebrastreifen stehen zu bleiben und den Radweg gänzlich zu blockieren.

Derzeit kommt noch eins drauf – die Tram-Linie 18 wird kurzgeführt und nutzt intensiv den Wendekreis. Eine Tram, die aus Richtung Rennweg in der Gasse fährt, fährt Parallel zum Radverkehr auf der anderen Straßenseite: als Tram sieht die nicht, wenn ich aufzeige, dass ich auf den Zebrastreifen abbiegen werde und als Radfahrer kann ich schwer sehen, wie weit die Tram vom Zebrastreifen entfernt ist. Dies brachte auch schon mehrmals Situationen in denen Tramfahrer den Zebrastreifen ignorieren.

Argentinienstraße

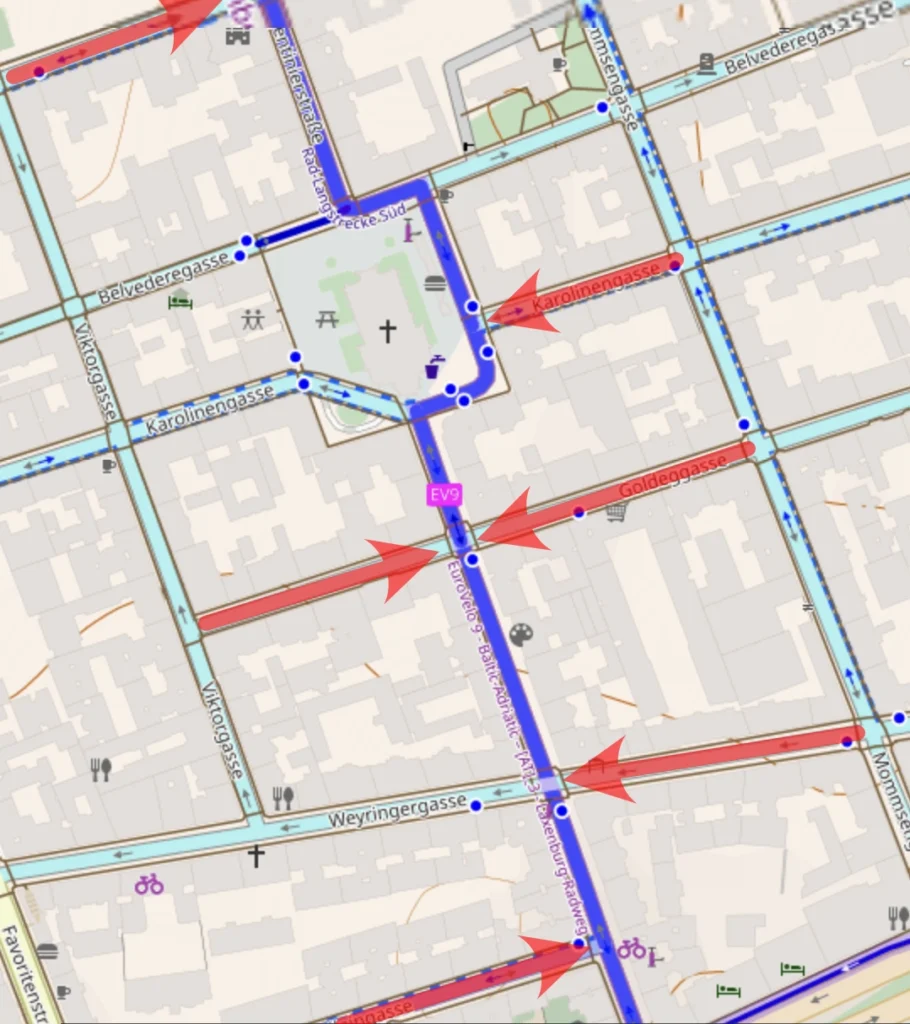

Die Argentinienstraße war bis letztes Jahr ein viel befahrener Radweg vom Hauptbahnhof zum Karlsplatz. Wiens Straßen/Radnetzt ist oft so “designt”, dass viele stark-befahrene Straßen keine Radwege haben, dafür Nebenstraßen verkehrsberuhigt, oder Einbahnstraßen sind, die dann für Radfahrer in beide Richtungen freigegeben werden. Oftmals ist es so, dass der gemütlichere/sichere Weg in die Stadt nicht die Routing App ist, sondern ein bestimmter gut ausgebauter Radweg allen Radverkehr einer Umgebung bündelt. Argentinienstraße war so einer und wurde daher 2024 auch zur vollen Radstraße ausgebaut. Die Umsetzung sie toll aus und fährt sich auch wirklich gut, hat nur einen großen Haken. Es wurden die Nebenstraßen nicht angefasst.

Fahrradstraßen in Österreich sind Straßen, für den Radverkehr, in denen jeder Fahrzeugverkehr verboten ist; “ausgenommen davon ist das Befahren mit den in § 76a Abs. 5 genannten Fahrzeugen sowie das Befahren zum Zweck des Zu- und Abfahrens” – Sprich, nichts ist Verboten, alles darf, wenn es nur sagt “ich muss da lang”.

Die meisten Nebenstraßen der Argentinienstraße sind Einbahnstraßen, die abwechselnd Verkehr in und aus der Argentinienstraße herausleiten. Somit wird Autoverkehr aktiv auf die schöne Fahrradstraße geleitet.

Haeussermannweg

Auch der Haeussermannweg ist eine Fahrradstraße, keine lange, aber eine mit viel WTFs.

Der Hauessermannweg ist eine Verlängerung der Barthgasse, die für Autos eine Einbahnstraße ist und im Hauessermannweg von Radfahrer in beide Richtungen genutzt werden darf. Auch hier den Autoverkehr in die Fahrradstraße leitet. Wirklich kritisch ist dies wenn man vom Radweg Anton-Kuhn-Weg kommend, die Baumgasse kreuzen muss um in den Hauessermannweg zu fahren. Regelmäßig kommen Autos aus dem Hauessermannweg wollen links auf die Baumgasse abbiegen und fahren dann in die Radfahrer, die gerade aus kreuzen.

So eine Verkehrssituation zu erzeugen ist schon What-The-Fuck genug, schärfer wird es, wenn man sich vor Ort die Beschilderung anguckt.

Wie gesagt, ist es wieder eine Fahrradstraße in die Autos mittels Einbahnstraßen hineingeleitet werden, ebeneso die Buslinie 80A … und gefördert vom Klima-Energie-Fonds “als Beitrag zum Umwelt- und Klimaschutz”. Danke für diese 80m.

Ich finde ja es braucht viel mehr Autofahrer-Shaming auf Fahrradstraßen.

Bonus Heustadelgasse

Übrigens sind in Wien das meiste Gassen, aber nicht alle. Als Deutscher hab ich bei “Gasse” ein Bild im Kopf. Jedoch nicht dieses Bild.